Überblick

Umfang und Komplexität regulatorischer Anforderungen stellen Banken bereits bei deren Analyse vor erhebliche Herausforderungen. Zudem müssen Banken – oft ad-hoc – Anfragen von Regulatoren bearbeiten und sich zeitnah zu Konsultationspapieren äußern.

Verfahren aus den Bereichen NLP und Machine Learning ermöglichen die effektive und effiziente Nutzung vorhandener Wissensressourcen.

Unsere Applikation Regulytics® ermöglicht die automatisierte Analyse regulatorischer sowie interner Texte nach inhaltlichen Gesichtspunkten.

Die App liefert keine umständliche allgemeine Berichte, sondern prägnante, maßgeschneiderte und sofortige Informationen zu inhaltlichen Ähnlichkeiten.

Damit können regulatorisch relevante Texte objektiv in den Gesamtkontext eingeordnet werden. Ähnliche Paragraphen in Regularien und internen Dokumenten können ebenso ermittelt werden wie Unterschiede in verschiedenen Dokument-Versionen.

Regulatorische Herausforderungen

Regularien wie IFRS 9, BCBS 239, FTRB, IRRBB oder die MaRisk-Novelle 2017 erfordern grundlegende Änderungen in Methoden, Prozessen und/oder Systemen der Banken.

Viele Regularien haben weitreichende Auswirkungen auf die Risiken, das Eigenkapital und damit das Geschäftsmodell der betroffenen Banken.

Die große Anzahl der finalen bzw. in Konsultation befindlichen Regularien gestaltet ein Monitoring der Anforderungen und Auswirkungen schwierig.

Die Regularien können verschiedene, miteinander zusammenhängende, Bereiche der Banken, wie Risk, Handel, Finance oder die IT betreffen.

Zudem existieren auch Zusammenhänge zwischen den Regularien; Gaps zu einer Anforderung entsprechen i.d.R. auch Gaps zu weiteren Anforderungen.

Die i.A. unterschiedliche Gesetzgebung in den verschiedenen Jurisdiktionen erhöht die Komplexität nochmals beträchtlich.

Innerhalb der Banken finden Auswirkungsanalysen und Vorstudien statt, um die Relevanz der Projekte einzustufen.

Zahlreiche Beratungsunternehmen führen Vorstudien sowie die eigentlichen Umsetzungsprojekte durch, die sich oft durch lange Laufzeiten und einen hohen Ressourcenbedarf auszeichnen.

Projekte binden interne Ressourcen und verschärfen Personalengpässe.

Externe Unterstützung ist kostspielig und erhöht den Koordinationsaufwand, insb. bei mehreren Dienstleistern.

Fehler in Vorstudien und Projekt-Anfangsphasen lassen sich nur schwer korrigieren.

Aufgrund der hohen Komplexität besteht Risiko, dass Auswirkungen und Interdependenzen nicht rechtzeitig erkannt werden.

Vorteile einer automatisierten Untersuchung

Geschwindigkeitssteigerung

Automatische Analysen können per definitionem sehr schnell und standardisiert durchgeführt werden.

Selbst mit herkömmlichen Laptops können binnen Minuten semantische Ähnlichkeiten in Dutzenden komplexer Regularien analysiert werden.

Damit können – etwa im Falle von Konsultationspapieren – Zuständigkeiten und Auswirkungen rechtzeitig erkannt und in die Stellungnahmen einbezogen werden.

Ressourcenschonung

Unsere Lösung ist – je nach Ausprägung – ohne spezielle Hard- und Software-Anforderungen lauffähig.

Der personelle Aufwand für die Nutzung und ggf. Weiterentwicklung ist äußerst gering und von der Anzahl der betrachteten Regularien weitgehend unabhängig.

Engpässe werden reduziert und Experten können sich auf anspruchsvolle Tätigkeiten fokussieren.

Entsprechend lassen sich Projektkosten reduzieren.

Objektivität

Die Ähnlichkeiten zwischen den Regularien auf Gesamt- und Paragraphen-Ebene liegen quantitativ vor und sind jederzeit reproduzierbar.

Unterschiede durch subjektive Präferenzen sind damit praktisch ausgeschlossen.

Analysen lassen sich nachvollziehbar dokumentieren.

Ergebnisse von Vorstudien und Aussagen externer Dienstleister können unvoreingenommen überprüft werden.

Fehlerreduktion

Automatische Analysen stellen eine effiziente Zusatzkontrolle dar.

Nichttriviale – und möglicherweise übersehene – Interdependenzen zwischen Regularien können identifiziert und berücksichtigt werden.

Insbesondere Flüchtigkeitsfehler sowie das Übersehen ggf. wichtiger Passagen lassen sich damit verringern.

Ggf. unbemerkte Gaps und Impacts können darüber hinaus entdeckt werden.

Wissensnutzung mittels Topic Analysis

Methoden und Tools

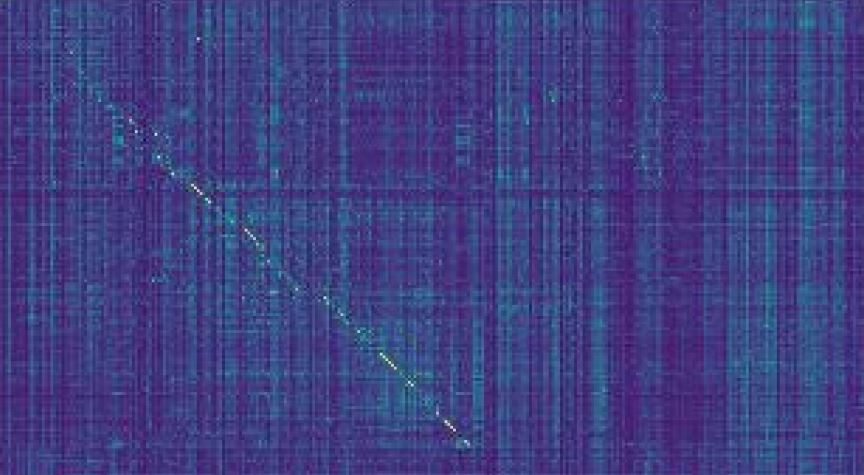

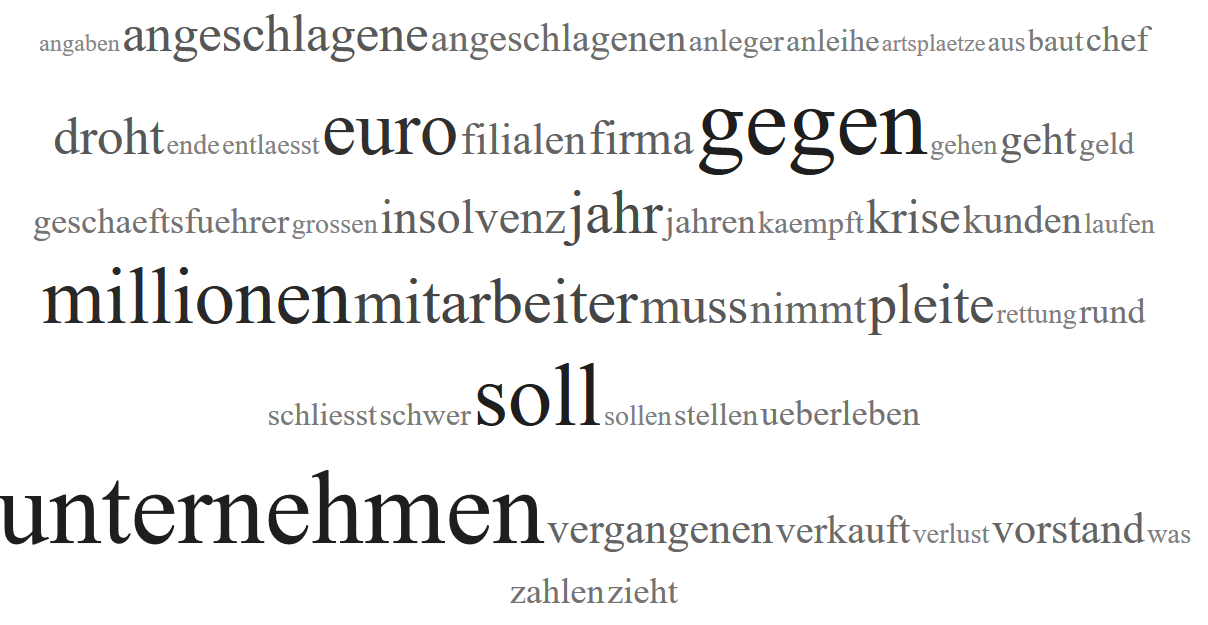

Die Verfahren des Natural Language Processing (NLP) im hier verwendeten Sinne ermöglichen semantische Analysen von Texten anhand darin vorkommender Themen (Topics) zur Identifizierung von Ähnlichkeiten bei beliebiger Granularität.

Bei der verwendeten Methode Latent Semantic Analysis (LSA bzw. Latent Semantic Indexing, LSI) erfolgt eine Reduktion der betrachteten Begriffe auf eine vorgegebene Anzahl von Themen und hierdurch eine Abbildung von Texten auf einen „semantischen Raum“.

Die Topic-Ermittlung entspricht dabei einem Unsupervised Learning-Prozess anhand vorgegebener Dokumente.

Neue Texte und Text-Komponenten können anschließend auf semantische Ähnlichkeiten hin untersucht werden.

Die Analysen erfordern Programme auf der Basis entsprechender Analysetools, wie z.B. Python oder R.

Angebotsstufen für einen regulatorischen Einsatz von Machine Learning-Verfahren

RiskDataScience ermöglicht Banken die beschriebenen Verfahren effizient und institutsspezifisch einzusetzen und weiterzuentwickeln. Entsprechend den jeweiligen Anforderungen werden dazu folgende drei Ausbaustufen vorgeschlagen.

Stufe 1: Methodik

- Einweisung in Methodik zum Latent Semantic Indexing regulatorischer Texte

- Übergabe und Installation der vorhandenen Python-Lösung zum automatisierten Einlesen und Zerlegen von Dokumenten sowie zur semantischen Analyse per LSI – bzw. je nach Kundenanforderung Unterstützung der Implementierung vor Ort

- Übergabe und Dokumentation der Visualisierungs- und Auswertetechniken

Bank ist in der Lage, Methodik zur Analyse regulatorischer Anforderungen eigenständig zu verwenden und weiterzuentwickeln

Stufe 2: Customizing

- Stufe 1 und zusätzlich

- Anpassung von Analyse-Einheiten (Dokument-Gruppen) gemäß Analysezielen der jeweiligen Bank

- Analyse der konkreten Regularien, Projekte, Methoden, Prozesse und Systeme zur Identifizierung optimaler Einsatzmöglichkeiten

- Entwicklung von Prozessen zur Erreichung der Analyseziele

- Kommunikation und Dokumentation der Ergebnisse an alle Stakeholder

Bank verfügt über gecustomizte Verfahren und Prozesse zur Analyse regulatorischer Anforderungen, etwa bzgl. Zuständigkeiten oder Methoden

Stufe 3: IT-Lösung

- Stufe 1, Stufe 2 und zusätzlich

- Spezifikation aller Anforderungen für eine automatisierte, ggf. web-basierte IT-Lösung

- Vorschlag und Kontaktierung möglicher Anbieter

- Unterstützung bei der Anbieter- und Tool-Auswahl

- Unterstützung bei der Planung der Umsetzung

- Fachliche und koordinative Begleitung des Umsetzungsprojekts

- Fachlicher Support nach Implementierung der IT-Lösung

Bank verfügt über automatisierte IT-Lösung zum effizienten semantischen Abgleich regulatorisch relevanter Textkomponenten.

Je nach Kundenwunsch ist eine flexible Ausgestaltung möglich. Gerne erläutern wir unseren Ansatz auch im Rahmen eines Vorab-Workshops.

Kontakt

Dr. Dimitrios Geromichalos

Founder / CEO

RiskDataScience GmbH

Nördliche Münchner Straße 47, 82031 Grünwald

E-Mail: riskdatascience@web.de

Telefon: +4989322096365